Design og UX /

Hvorfor fant jeg ikke gull i ChatGPT?

Er det flere enn meg som synes det har vært vanskelig å knekke koden på ChatGPT og andre generative AI-verktøy? Som lurte på hva alle de andre gjorde som hentet gull ut av disse løsningene? Et inputfelt, det var alt jeg fikk. Og det jeg pleide å gjøre funket ikke. Det handler om våre ulike mentale modeller.

Skriv langt?

Jeg har vokst opp med flere ulike måter å gå fram på for å få svar på ting jeg lurer på. Før internett slo vi opp i leksikon og gikk alfabetisk til verks for å finne ordet vi ville vite mer om. Eller vi spurte en voksen. Da jeg var student på 90-tallet søkte vi etter artikler på biblioteket med BIBSYS. Da var det viktig å søke på ordene som artiklene var tag’et med. Så kom Google, og søket fortsatte med stikkord. Jo færre og mer presise ord - jo bedre treff fikk du. Så kom ChatGPT og oppskriften er skriv langt, jo lenger jo bedre. Vær tydelig og spesifikk! Helt motsatt av hva jeg har pleid å gjøre.

Large language models, LLM

For å prøve å knekke koden på hvordan jeg kan bruke generativ AI har jeg forsøkt å sette meg inn i hva det er. ChatGPT og andre generative AI-verktøy er basert på språkmodeller (LLM). LLM forstår ikke ord, men tall. Derfor gjøres alle ordene om til tall. Det trenger ikke være ord, LLM brukes også på bilder, lyd og video.

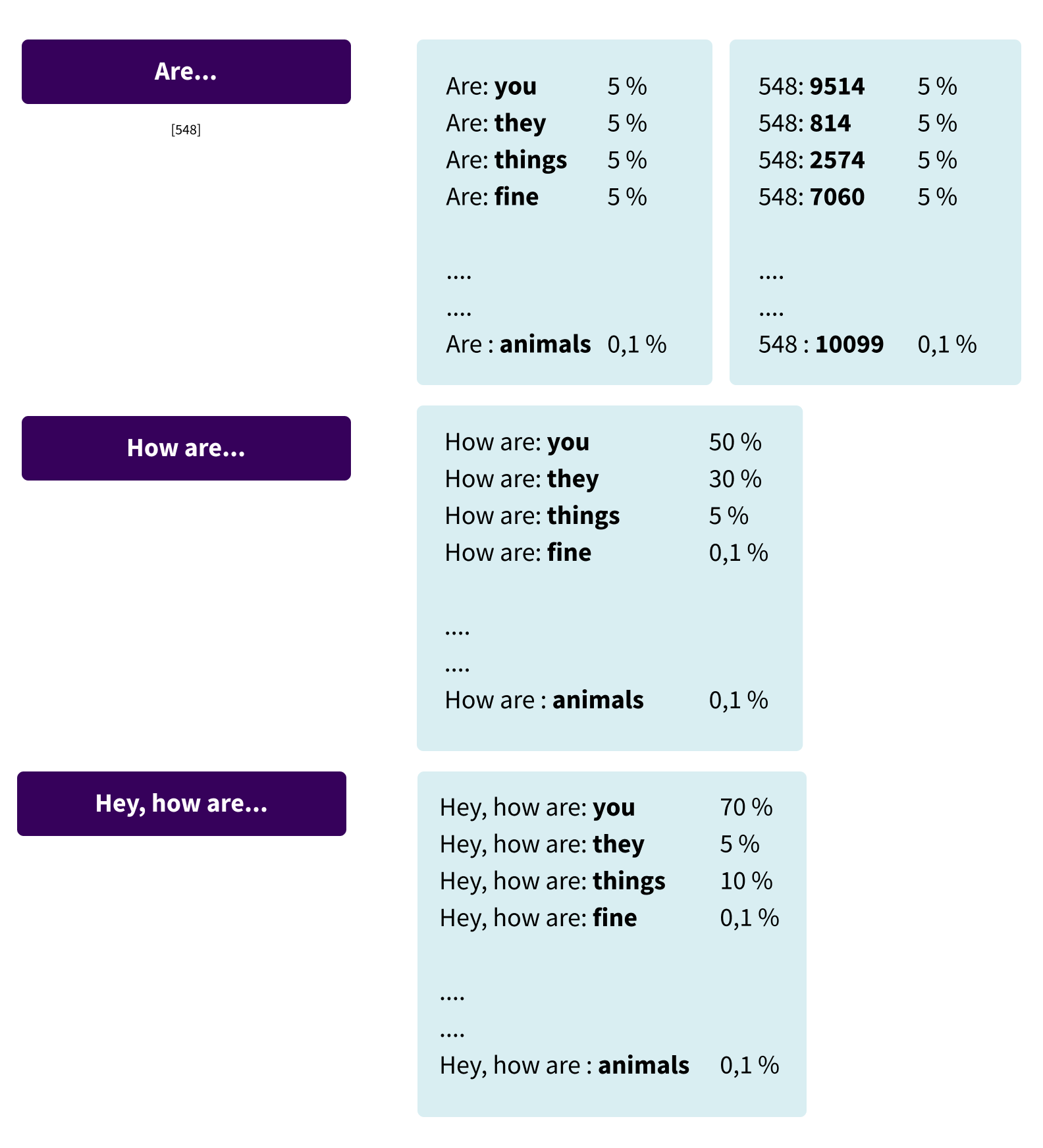

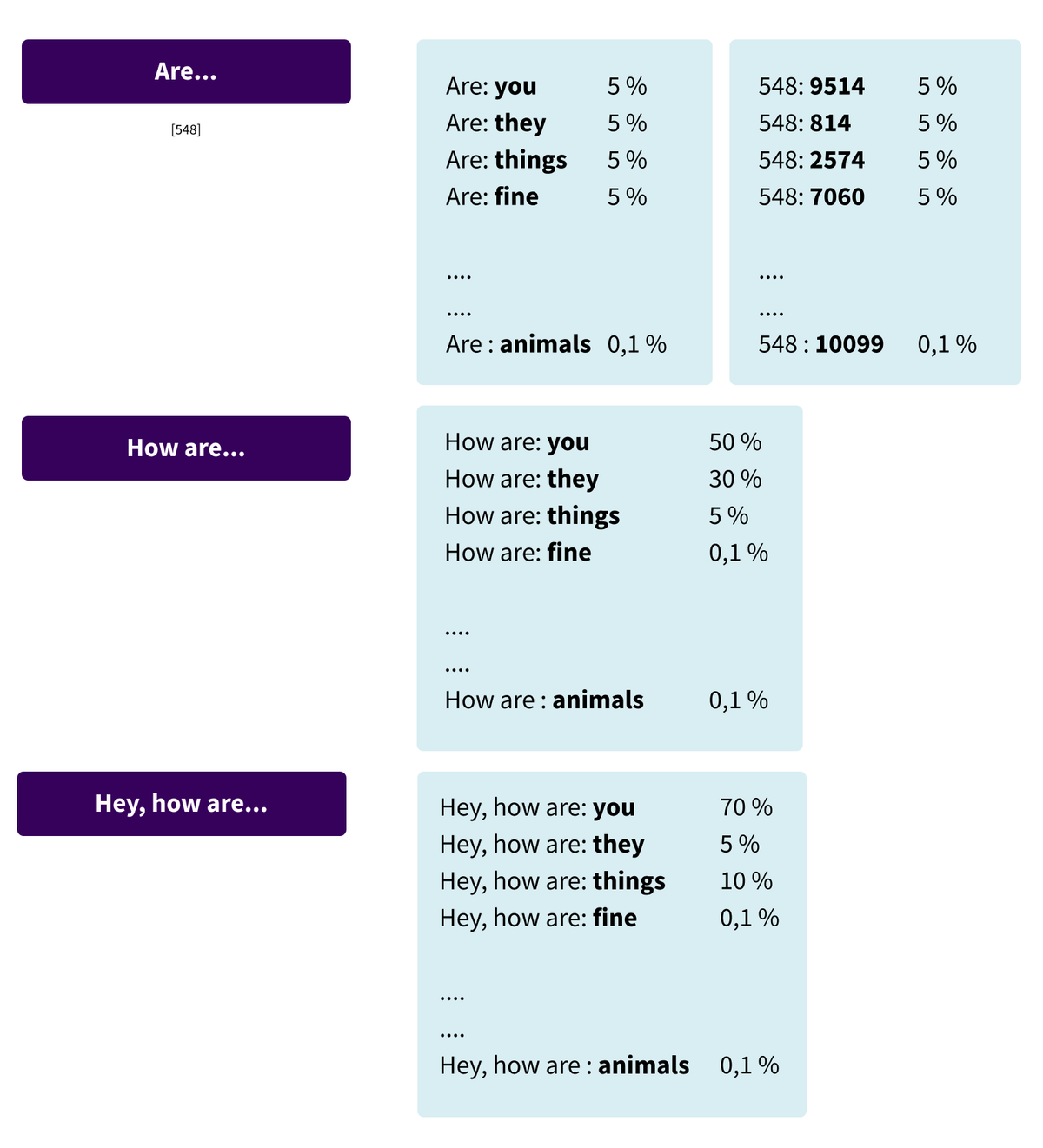

I Oxford English Dictionary er det 171.476 ord, og alle disse ordene gjøres om til tall fra 1 – 171.476. Når vi spør ChatGPT vil den gå inn i det store sorte hullet med tall (ord) den har trent på og beregne sannsynligheten for neste tall (ord) i en setning. Jo mer kontekst den får jo bedre klarer den å gjette.

Aha! - det er derfor jeg skal skrive langt, den må ha setninger den kan beregne statistikk uti fra. Jo mer kontekst, jo bedre blir den.

Modellen beregner sannsynligheten for neste ord i setningen. Jo bedre kontekst, jo bedre blir teksten. Eksempelet er hentet fra “The conspiracy to make AI seem harder than it is!" av Gustav Söderström. Anbefales å se!

En annen ting er at jeg ikke vet hva som er kilden til det ChatGPT presenterer for meg. Maskinene er blitt flinke, men de er ikke smarte. De kan ikke reflektere over hva de svarer, og svaret er hentet fra en enorm mengde tekst som er gjort om til tall og som de har trent på. Den bruker teksten (tallene) den har og vil alltid gi deg et svar basert på statistikk og sannsynlighet i dataene den har.

Ikke søke, men promte

Dette forventet OpenAI som har laget ChatGPT at jeg bare skulle forstå, intuitivt. De har gitt meg et inputfelt – ikke noe mer. Noen knekker koden raskere enn andre, hvorfor er det slik? Det handler om ulike mentale modeller. Den mentale modellen i dette tilfellet er en persons forståelse for hvordan et søk virker og hvordan egen aktivitet kan påvirke det.

Min mentale modell da jeg begynte å bruke ChatGPT var basert på mine tidligere erfaringer og påvirket mine antagelser om hvordan systemet fungerer. Når jeg søker på en maskin bruker jeg stikkord. Når jeg snakker med en person forklarer jeg gjerne litt mer for å få et godt svar. Nå skal jeg altså snakke med en maskin! Det ikke er et gammeldags søk jeg skal gjøre i inputfeltet i ChatGPT og andre chatbots. Jeg skal lage prompts, som er det instruksen til ChatGPT kalles.

Det er ikke et gammeldags søk jeg gjør i inputfeltet i ChatGPT!

Dele personlig informasjon?

En kollega tipset meg om at jeg kan legge inn en beskrivelse av meg selv i flere av løsningene slik at svarene jeg får er mer tilpasset meg. Det tok litt tid før jeg fant ut hvordan, og følte at jeg var godt i gang med en beskrivelse på en datingside, noe jeg ikke har erfaring med. Jeg har vært gift med samme mann lenger enn det har eksistert digitale datingtjenester. Jeg er sånn middels til stede på sosiale medier, og liker ikke å dele alt mulig på internett. Dette synes jeg at var litt utfordrende.

Ulike mentale modeller

Dette var mine erfaringer som påvirket min adferd i starten. Andre vil ha andre erfaringer som påvirker deres mentale modeller og hvordan de vil bruke tjenestene. Mentale modeller er noe av det UX-designere kartlegger når de skal lage brukervennlige løsninger. Hvordan hjelpe folk i gang med tjenester som representerer noe helt nytt, slik som for eksempel AI. Er det noen UX’ere som jobber i OpenAI? Heldigvis jobber det UXere i andre selskaper som bruker spåkmodeller.

Ja takk, begge deler

Perplexity.ai er en tjeneste som har tatt brukernes mentale modeller på alvor når de skal bruke LLM. Jeg kan bruke stikkord slik jeg er vant til. Brukeropplevelsen blir løftet med AI slik at i stedet for å få mange treff jeg må slå opp, brukes LLM til å lage en oppsummering av innholdet i treffene for meg. I tillegg legger den til kildene den har brukt slik at jeg kan sjekke dem ut. Jeg kan stille oppfølgingsspørsmål slik at jeg nærmer meg en samtale med løsningen. Hvis jeg velger «Copilot» får jeg forslag til oppfølgingsspørsmål. Dette er en lur måte å «lære opp» brukerne på når noe er helt nytt.

Lurer på om folk flest vet hva Copilot er?

Bing har også lagt seg på en litt mer brukervennlig linje. I tillegg til å søke på «gamlemåten» lager den også en oppsummering av de mest relevante funnene med lenker til kilden. Den foreslår også oppfølgingsspørsmål slik at jeg enklere kommer meg videre. Jeg må riktignok velge fanen «Copilot» for å finne denne tjenesten.

Jeg har også prøvd Googles nye Gemini som skal være helt fantastisk og veldig rask. Den har fine eksempler som viser meg hvordan jeg lager en bestilling – et promt - på en tekst. Det var veldig oppklarende og anbefales til dere som kjenner dere igjen i det jeg beskriver. Det viser seg at Gemini bommet kraftig på brukernes forventninger med bildegenereringstjenesten sin. I et forsøk på å være politisk korrekt klarte den ikke å skape historisk korrekte bilder.

Hjelp til å lage promts

Et annet verktøy som kan gjøre det enklere for meg å bruke chatbots er Retrieval Augmented Generation (RAG). Den kan koble mine enkle spørsmål til relevant informasjon hos bedriften slik at det legges på relevant kontekst før de sendes til språkmodellen (LLM). På den måten genererer chatboten svar basert på mine spørsmål i en relevant kontekst, som jeg helt sikkert ikke hadde lagt til på egenhånd. Dette er en tjeneste som øker brukervennligheten ved at den hjelper brukeren å få relevante svar slik at de får utført oppgaven de kom til chatboten for å løse. Kilden vil også være kjent.

Øvelse gjør mester 💪

Jeg synes at Perplexity, Bing og Gemini er enklere å bruke enn ChatGPT. Og kanskje gjør de meg flinkere til å slutte «å søke» og heller «snakke», dvs promte med chatbots på sikt? Det finnes faktisk et eget fagfelt for dette; promtengineering. Det er prosessen med å strukturere tekst som kan tolkes og forstås av en generativ AI-modell. Det er ikke bare språkmodellen som skal trenes, brukeren må også trenes. Jeg har også hørt at det blir vanskeligere å lære seg mye ting når man blir eldre. Øvelse gjør mester!